La última barrera de nuestra privacidad.

En un mundo donde la tecnología avanza a pasos agigantados, el uso de inteligencia artificial (IA) para «mejorar» la identificación biométrica, especialmente en huellas dactilares y reconocimiento facial, está revolucionando la seguridad (de los estados). Pero esta tendencia plantea preguntas cruciales sobre la privacidad y la vigilancia, temas que deberían preocuparnos profundamente. Sobre todo teniendo en cuenta que no cuentan -estos métodos- en la mayoría de las ocasiones con nuestro consentimiento.

Los avances permiten a los sistemas encontrar coincidencias en patrones de huellas, e incluso identificar rasgos específicos dentro de la estructura de las huellas o los rostros. Este nivel de precisión podría ser útil para acceder a cuentas bancarias o atravesar fronteras, pero también representa una amenaza real para la privacidad.

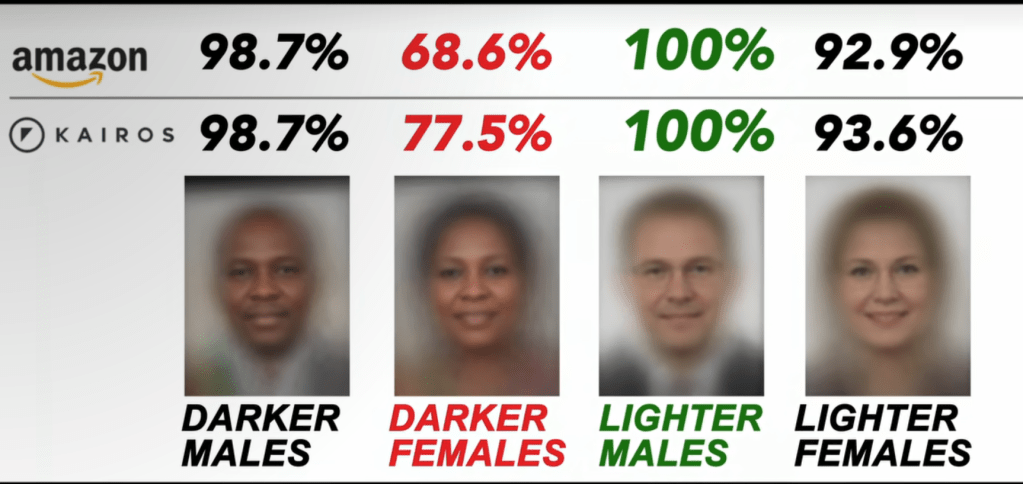

La preocupación radica en la forma en que la IA maneja nuestra identidad biométrica. Las redes neuronales y otros sistemas de IA han demostrado mejorar significativamente en el reconocimiento de imágenes gracias a su capacidad para analizar grandes volúmenes de datos. Sin embargo, en la práctica, estos sistemas no son perfectos y enfrentan limitaciones, como la dificultad de identificar correctamente huellas parciales o rostros bajo condiciones no ideales. Aun así, el impacto es inquietante cuando recordamos que los algoritmos no siempre revelan en qué características basan sus decisiones, lo que hace difícil comprender cuándo ocurren errores o sesgos.

Se puede leer más sobre el problema del sesgo codificado en este artículo ( https://www.media.mit.edu/articles/facial-recognition-software-is-biased-towards-white-men-researcher-finds/ )

La Última Frontera de la Privacidad

La cuestión de la privacidad va mucho más allá de un simple fallo técnico. La cara y las huellas dactilares son, en muchos sentidos, la última barrera de nuestra intimidad. Una huella o un escaneo facial no es una simple contraseña que podamos cambiar; estos datos, una vez registrados y potencialmente mal utilizados, nos exponen de manera irreversible. Si la IA se convierte en un recurso fiable para sistemas de seguridad, estamos cediendo el control de nuestra identidad más allá de nuestro alcance.

Además, surge el problema de quién define los umbrales de seguridad en estos sistemas. Para que una tecnología sea conveniente en aplicaciones de bajo riesgo (como desbloquear un teléfono), los desarrolladores permiten ciertos márgenes de error. Sin embargo, para aplicaciones de alto riesgo, como el acceso a información sensible o situaciones judiciales, estos márgenes se reducen drásticamente, aunque los errores siguen existiendo. A esto se suma el potencial de un uso sesgado o incluso discriminatorio de estas tecnologías, como ya se ha documentado en ciertos sistemas de reconocimiento facial.

¿Qué Nos Espera?

Estos avances tecnológicos dejan entrever una realidad que todos deberíamos considerar críticamente. La IA no está lista para decidir sola si alguien ha cometido un crimen o para realizar un seguimiento total de nuestra identidad en cualquier contexto. Los errores pueden llevar a la detención de inocentes, o al uso indebido de nuestra información biométrica, y debemos preguntarnos si el beneficio que esto aporta justifica los riesgos.

En un mundo donde la línea entre seguridad y privacidad se difumina cada vez más, es esencial que cuestionemos hacia dónde nos lleva esta tecnología. Si bien los avances de la IA en biometría parecen emocionantes, necesitamos proteger la privacidad de nuestras características físicas con una visión ética que ponga a las personas por encima de la eficiencia tecnológica.

El aspecto más relevante podemos considerar que es el dilema entre precisión tecnológica y privacidad individual en el uso de IA para identificación biométrica. Aunque la inteligencia artificial mejora la precisión en la identificación de huellas dactilares y rostros, facilitando el acceso seguro y rápido en ciertas aplicaciones, también plantea serios desafíos en cuanto a la privacidad y los posibles errores.

Este dilema se agrava debido a la opacidad de los modelos de IA, ya que no siempre está claro en qué características basan sus decisiones. Esto implica que, aunque el sistema pueda ser útil en aplicaciones cotidianas, aún existen riesgos significativos cuando se utiliza en contextos críticos, como la aplicación de la ley. Un error o un sesgo en estos sistemas podría tener consecuencias devastadoras, como identificar erróneamente a personas inocentes o permitir accesos indebidos.

Es crucial analizar el equilibrio entre los beneficios de la IA en biometría y las amenazas a la privacidad, donde las decisiones éticas sobre el uso de esta tecnología resultan fundamentales.