Se bienvenido a estas tierras digitales...

...especialmente si eres un molino....

La última barrera de nuestra privacidad (II).

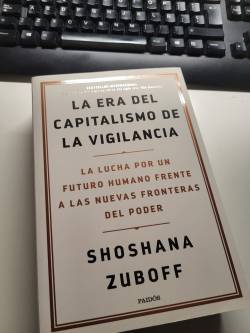

La privacidad, en la era digital, ha sido invadida por tecnologías que prometen mejorar la seguridad, pero que simultáneamente erosionan nuestra autonomía. La implementación masiva de herramientas como el reconocimiento facial refleja no solo avances técnicos, sino también un modelo de poder que redefine las relaciones entre ciudadanos, gobiernos y corporaciones. Este fenómeno, profundamente explorado en el libro «La era del capitalismo de la vigilancia» de Shoshana Zuboff (que me sorprende aún más en la segunda lectura), conecta con el dilema planteado en los artículos que comienzan a emerger tratando el tema de la privacidad, destacando cómo estas tecnologías no solo transforman nuestra privacidad, sino que también refuerzan un modelo económico centrado en la extracción y explotación de datos personales.

Zuboff describe el capitalismo de la vigilancia como un nuevo sistema económico en el que los datos sobre nuestras acciones, comportamientos y emociones se recolectan sin nuestro consentimiento explícito, se procesan y se comercializan para generar predicciones cada vez más precisas sobre nuestro futuro comportamiento. Este sistema opera bajo una lógica extractiva similar a la de los antiguos colonialismos, donde el territorio a conquistar es la experiencia humana misma (la potencia de esta afirmación todavía me deja impactado). El reconocimiento facial se inserta perfectamente en este paradigma, permitiendo una vigilancia omnipresente que convierte nuestros rostros en datos monetizables, mientras se presenta como una herramienta para reforzar la seguridad.

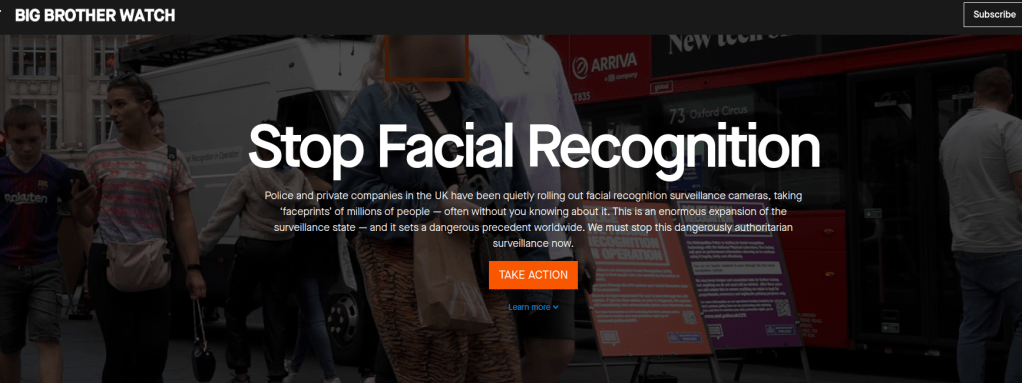

Estas tecnologías, inicialmente concebidas para prevenir actos terroristas por ejemplo, se han expandido para abarcar usos que van mucho más allá de su propósito original. Por ejemplo, bases de datos que se diseñaron originalmente para identificar criminales se utilizan ahora para monitorizar a disidentes políticos o controlar el acceso a servicios esenciales. Esto crea un sistema que no solo vigila, sino que también implementa disciplina y controla, moldeando el comportamiento humano a través del miedo a ser observado. Conviene en este punto traer a colación el sistema de crédito social chino y como raiz de este asunto al postulado de Jeremy Bentham y su panopticón. En este sentido, el reconocimiento facial se alinea con lo que Zuboff llama «instrumentación conductual», un proceso en el que la vigilancia constante modifica nuestras decisiones. Cuando las personas saben que están siendo observadas, sus acciones cambian; se autocensuran, evitan ciertas actividades o incluso lugares (Panopticón). Este efecto no solo amenaza la privacidad individual, sino también las bases mismas de la democracia (y esto ya es muy serio), ya que el espacio público, donde se deben ejercer derechos como la protesta o la libre expresión, se transforma en un entorno de control absoluto.

Íntimamente relacionado con lo expuesto, encontramos el problema de los sesgos en los algoritmos de reconocimiento facial, un punto que Zuboff considera central en el capitalismo de la vigilancia. Estas tecnologías no son neutrales; heredan y amplifican las desigualdades existentes, afectando desproporcionadamente a grupos marginados. Los algoritmos, entrenados con datos históricos, reproducen patrones discriminatorios que convierten a ciertos colectivos en objetivos privilegiados de la vigilancia. Esto refuerza sistemas de exclusión que ya están presentes en nuestras sociedades, consolidando un control asimétrico que beneficia a los más poderosos. Esto ocurre y ocurrirá siempre.

Además, Zuboff alerta sobre cómo el capitalismo de la vigilancia redefine el concepto de consentimiento. En su lógica, los usuarios «aceptan» ser vigilados como una condición para participar en la vida digital, pero este consentimiento es más aparente que real. De forma similar, el reconocimiento facial implementado en espacios públicos no deja espacio para el consentimiento informado; simplemente somos capturados por las cámaras, y nuestros datos se procesan sin nuestro conocimiento o control. Esto nos convierte en sujetos pasivos de un sistema que prioriza la monetización de nuestros datos sobre nuestras libertades fundamentales. En Reino Unido existe una iniciativa denominada Big Brother Watch (el que vigila al Gran Hermano) que pretende concienciar sobre este problema.

La promesa de seguridad, uno de los argumentos más utilizados para justificar estas tecnologías, se desmorona al observar sus implicaciones a largo plazo. Las tasas de falsos positivos y negativos no solo limitan la eficacia del reconocimiento facial, sino que también aumentan los riesgos de abuso. Zuboff complementa esta crítica al señalar que la obsesión por recopilar datos no siempre se traduce en un incremento real de la seguridad. Más bien, esta acumulación desmedida sirve para alimentar sistemas que se vuelven cada vez más opacos e incontrolables, concentrando el poder en manos de quienes poseen las infraestructuras tecnológicas. No nos sorprenderá que las compañias de seguros estén detrás de estos sistemas (como ávidos compradores de la información que atesoran).

La raíz de mi preocupación por esta desmedida tendencia a la biometria invasiva se encuentra en la ausencia de regulación adecuada pues es los que agrava estos problemas. Para Zuboff, la regulación es una de las pocas herramientas que pueden limitar el alcance del capitalismo de la vigilancia, imponiendo salvaguardas que devuelvan a los ciudadanos el control sobre sus datos. La implementación de estas regulaciones enfrenta la resistencia de actores con intereses económicos y políticos que se benefician de la expansión de estas herramientas. Abrimos el melón de la especulación … .

¿Estamos dispuestos a aceptar la pérdida de nuestra privacidad como el precio a pagar por la comodidad y la seguridad? Zuboff nos advierte que esta dinámica es evitable; es el resultado de decisiones tomadas por actores específicos, y como tales, pueden ser desafiadas y revertidas. Requiere una movilización colectiva que cuestione la narrativa dominante de que la tecnología es inherentemente buena y neutral. Y lo es, pero no lo es si el uso no es trasparente.

Impacto de la IA en la Innovación y Seguridad Empresarial

El avance vertiginoso de la inteligencia artificial generativa ha traído consigo una disrupción (como me gusta esta palabra) sin precedentes en la manera en que concebimos la creatividad y la propiedad del conocimiento. En mi blog, en entradas como La última barrera de nuestra privacidad o Cuando los LLM decidan por nosotros, ya he tratado temas sobre cómo la IA desafía nuestros principios éticos y legales más fundamentales. Pero al respecto de cómo aprenden (entrenan) los modelos ¿no os preguntáis sobre el origen del conocimiento? ¿quién puede reclamar la autoría y propiedad de lo que genera la IA? En mi entrada Democratización de la innovación ya avancé algo sobre este tema.

Los modelos de IA actuales, como los que subyacen en herramientas de uso masivo, son el resultado de entrenamientos basados en enormes cantidades de datos, muchos de ellos obtenidos sin consentimiento explícito de sus creadores originales. Este proceso, aunque tecnológicamente impresionante, levanta cuestiones éticas profundas. Por ejemplo, ¿es legítimo que una empresa genere valor económico a partir de un conocimiento que, en esencia, proviene del esfuerzo y la creatividad humana acumulada? ¿Peligran los royalties de las patentes?

El panorama jurídico es desigual y caótico (no citaremos el caso de China, que no hay por dónde cogerlo). Mientras que en países como Estados Unidos, los derechos de autor y las patentes exigen una contribución humana significativa, otras jurisdicciones, como Japón, adoptan una postura más permisiva, permitiendo entrenar sistemas de IA incluso con contenido protegido por derechos de autor . Este contraste refleja una crisis de armonización legal en un contexto global donde la IA no reconoce fronteras.

En Europa, la situación es distinta. La Unión Europea ha establecido el Reglamento de Inteligencia Artificial (AI Act), que entró en vigor en agosto de 2024. Este reglamento busca garantizar que los sistemas de IA sean seguros, éticos y respetuosos con los derechos fundamentales de las personas . Clasifica las aplicaciones de IA en función de su riesgo y establece obligaciones específicas para cada categoría. En España, la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA) se encarga de supervisar la aplicación de este reglamento y está preparando la implementación de certificaciones sobre el uso de IA en el país . Estas certificaciones buscan garantizar la seguridad y el cumplimiento normativo, aunque podrían retrasar la llegada de nuevos productos al mercado.

Sin embargo, el impacto va más allá de lo ético o legal y se extiende a la seguridad corporativa. Utilizar datos no autorizados en el entrenamiento de modelos de IA puede exponer a las empresas a riesgos significativos, desde litigios por infracción de derechos hasta daños reputacionales. Las organizaciones que implementan sistemas de IA sin un control adecuado sobre las fuentes de datos pueden enfrentarse a consecuencias críticas, como ataques cibernéticos dirigidos, ya que los modelos generativos podrían filtrar, intencionadamente o no, información sensible aprendida de sus conjuntos de datos. Este riesgo subraya la necesidad de adoptar medidas de transparencia y trazabilidad en la construcción y el despliegue de estos sistemas. Tuve el honor de participar en el Grupo de Trabajo de Inteligencia Artificial para asesorar al Parlamento Andaluz y en el seno de este grupo pude destacar la necesidad de trabajar con fuentes de datos autorizadas y con modelos auditados.

En suma de lo expuesto, en entradas anteriores (https://elquijotedigital.com), he analizado cómo la privacidad y la autonomía están en juego frente a la capacidad de la IA para aprender y decidir por nosotros. Aquí la cuestión es más amplia: la IA no solo consume datos, sino que transforma ese conocimiento en nuevos productos que reconfiguran nuestra noción de creatividad.

¿Es justo proteger estas creaciones cuando la IA se nutre de décadas de conocimiento humano, muchas veces sin el debido reconocimiento?

El desafío no es solo tecnológico, sino también ético, político y de seguridad. A medida que estas tecnologías redefinen nuestras capacidades, debemos plantearnos si los marcos legales actuales son suficientes para proteger tanto a los creadores humanos como a las innovaciones que surgen de esta colaboración híbrida entre humanos y máquinas. Y, más importante aún, debemos garantizar que las decisiones empresariales alrededor de la IA no comprometan su propia estabilidad ni la confianza de sus stakeholders.

Reflexionar sobre este tema, como he argumentado en mis publicaciones, es esencial para entender hacia dónde nos dirigimos como sociedad en esta nueva era digital.

Por lo tanto, me gustaría provocar una discusión sana y fructífera en torno a este tema: ¿Cómo crees que deberíamos equilibrar innovación tecnológica, seguridad y respeto por el conocimiento humano?

He encontrado una entrada en un blog que también trata este tema. La dejo aquí para ampliar la información. Y un post de linkedIn que data de 2018.

Privacidad en la Era Digital

En un mundo marcado por la digitalización tan acelerada, las políticas de privacidad han evolucionado (aunque de manera dispar y no tan rápido como la digitalización) para responder a la creciente preocupación sobre el manejo de los datos personales. Desde finales del siglo XX las políticas de privacidad han reflejado tanto avances tecnológicos como una mayor sensibilidad regulatoria y social. Siempre para dar respuesta a avances como el comercio electrónico y a la protección de datos.

A finales del siglo XX, las políticas de privacidad comenzaron a consolidarse como herramientas utiles para la transparencia y confianza. En [1] los autores ofrecieron (2007) una primera revisión integral de los lenguajes de estas políticas, sentando las bases para su análisis sistemático. La entrada en vigor del Reglamento General de Protección de Datos (GDPR) en mayo de 2018 marcó un hito global, no sólo para las empresas europeas, sino también para aquellas que operan a nivel internacional, estableciendo un estándar de cumplimiento obligatorio. La multa de 50 millones de euros a Google en 2019 por falta de transparencia en la gestión de datos personales supuso un fenomenal respaldo a este marco que subrayó la importancia de la claridad en las prácticas organizativas.

Hoy en día, +162 países han promulgado leyes de privacidad de datos, mientras que +20 trabajan en proyectos legislativos. La investigación en políticas de privacidad ha ampliado su alcance a numerosos sectores siendo los más relevantes sectores como el de salud. A todo esto se le suma la aparición de herramientas basadas en aprendizaje automático y procesamiento del lenguaje natural que, como añadido importante, permiten analizar aspectos como la legibilidad, la accesibilidad y el cumplimiento normativo de estas políticas.

Numerosos investigadores han destacado notables discrepancias entre las prácticas de manejo de datos y las declaraciones de privacidad, evidenciando la necesidad de sistemas de revisión y control más robustos. Sectores como el de la salud enfrentan desafíos específicos relacionados con la claridad, la transparencia y el respeto a los derechos de los usuarios.

Los marcos regulatorios (políticas), liderados por la Unión Europea con el GDPR, han establecido un estándar global para el manejo ético y legal de los datos. Sin embargo, la implementación de estas politicas enfrenta obstáculos, desde la falta de uniformidad en las leyes regionales hasta las brechas en la comprensión y aplicación por parte de las organizaciones. Casos como la aplicación de técnicas de aprendizaje (machine learning, ML) para avanzar en la investigación sobre la legibilidad de las políticas demuestran que, en muchos sectores, estas políticas permanecen inaccesibles para el usuario promedio, lo que dificulta la confianza y la transparencia.

La inteligencia artificial generativa y otros campos más amplios (como el ML) añade otra capa de complejidad. Por un lado, ofrece herramientas para analizar y mejorar estas políticas; por otro, plantea riesgos éticos y de seguridad que requieren atención regulatoria. Desde la creación de deepfakes hasta el uso malintencionado en ataques de ingeniería social, estos modelos amplifican los desafíos inherentes al manejo de datos sensibles.

En síntesis, las políticas de privacidad han recorrido un largo camino, pero su desarrollo sigue siendo esencial en un mundo donde la tecnología redefine constantemente las reglas del juego. La colaboración entre reguladores, investigadores y la industria es crucial para garantizar que estas políticas evolucionen en paralelo con las tecnologías que buscan regular, promoviendo un equilibrio entre innovación, ética y derechos fundamentales.

Indudablemente, las ténicas de IA y ML han favorecido analizar la aplicación y expresión de éstas políticas, demostrando que aún queda mucho campo en el que avanzar.

Referencias

[1] Ponnurangam Kumaraguru, Lorrie Cranor, Jorge Lobo, and Seraphin Calo. 2007. A survey of privacy policy languages. 3rd Symposium on Usable Privacy and Security: Workshop on Usable IT Security Management (USM’07).ACM.