Se bienvenido a estas tierras digitales...

...especialmente si eres un molino....

Volver a casa: Una experiencia inolvidable en mi alma mater (UGR). Cátedra Telefónica – UGR.

Regresar a la Universidad de Granada, mi alma mater, para impartir una conferencia sobre los Fundamentos de seguridad de hardware y TPM 2.0 ha sido una experiencia profundamente significativa. No solo fue una oportunidad para compartir conocimiento, sino también para reconectar con la institución que marcó los inicios de mi trayectoria profesional.

En el marco de la Cátedra Telefónica-UGR sobre IA, Ciberseguridad y Sociedad Cognitiva, abordamos los desafíos y oportunidades de los estándares modernos de seguridad como el TPM 2.0, un pilar esencial para la confianza digital en dispositivos empotrados y sistemas críticos. Fue inspirador ver el interés de estudiantes, docentes y profesionales que, con sus preguntas y reflexiones, enriquecieron aún más la experiencia.

Volver a las aulas y los espacios donde comenzó todo me recordó lo importante que es contribuir al crecimiento de la próxima generación de expertos en ciberseguridad. Gracias a todos los asistentes por su energía, curiosidad y ganas de aprender.

Granada, siempre es un placer volver a ti. ❤️

Enlace a la Cátedra Telefónica-UGR

Este regreso ha sido especialmente emotivo, ya que este año se cumplen 25 años desde que me gradué como parte de la primera promoción de ingenieros de la ETSIIT. Recordar aquello junto con las lecciones aprendidas ha sido un viaje lleno de nostalgia y orgullo. Saber que la ETSIIT sigue formando mentes brillantes que afrontan los desafíos tecnológicos del futuro es un motivo de esperanza y admiración.

Agradezco la invitación a la Dirección de la Cátedra.

¿Confidential Computing o Cryptographic Computing? El Futuro de la Computación Segura.

En un mundo donde los datos son el nuevo oro, proteger su privacidad y seguridad se ha convertido en una prioridad esencial. La computación segura, que busca mantener los datos protegidos incluso mientras están siendo procesados, es una respuesta a los desafíos impuestos por normativas más estrictas y ataques cibernéticos cada vez más sofisticados. Dentro de este ámbito, dos enfoques destacan como soluciones líderes: la computación criptográfica (destacanado dentro de ésta a la criptografía homomórfica) y la computación confidencial. Aunque ambos comparten el mismo objetivo, sus métodos y aplicaciones presentan diferencias clave que vale la pena explorar.

La computación criptográfica se apoya en técnicas avanzadas como el cifrado homomórfico y el cómputo multipartito seguro. Estas tecnologías permiten realizar cálculos directamente sobre datos cifrados, sin necesidad de descifrarlos, asegurando un nivel extremo de privacidad. Esto es particularmente útil en situaciones donde los datos deben permanecer protegidos de todos los actores involucrados, incluyendo los sistemas que ejecutan los cálculos. Sin embargo, este enfoque enfrenta importantes desafíos prácticos. La complejidad matemática que lo respalda implica tiempos de procesamiento significativamente mayores, lo que lo hace menos eficiente para aplicaciones intensivas como el aprendizaje automático. Además, su implementación requiere conocimientos especializados en criptografía, lo que puede limitar su adopción en organizaciones con recursos técnicos más limitados.

Por otro lado, la computación confidencial utiliza entornos de ejecución confiables, también conocidos como TEEs, para crear espacios seguros dentro del hardware donde los datos pueden ser procesados directamente. A diferencia de la computación criptográfica, este enfoque permite trabajar con datos en texto plano, aprovechando todo el poder del procesador. Esto se traduce en un alto rendimiento y una implementación relativamente sencilla, especialmente porque grandes proveedores en la nube, como AWS o Azure, ya integran estas tecnologías en sus servicios. Sin embargo, esta dependencia del hardware introduce ciertos riesgos. Un compromiso en el diseño de los TEEs podría exponer información sensible, y los usuarios deben confiar plenamente en las garantías ofrecidas por los fabricantes.

Ambos enfoques tienen aplicaciones concretas en diversos sectores. En el ámbito de la salud, la computación criptográfica permite a las organizaciones entrenar modelos predictivos sin compartir datos sensibles de los pacientes, mientras que la computación confidencial es una excelente opción para integrar servicios en la nube de manera eficiente y segura. En el sector financiero, la computación confidencial facilita la construcción de modelos con datos distribuidos entre diferentes sucursales, mientras que la criptografía avanzada asegura la privacidad total cuando la confidencialidad es prioritaria.

Elegir entre computación criptográfica y confidencial depende en gran medida de las necesidades específicas de cada caso. Si la prioridad es la máxima seguridad y la privacidad absoluta, aunque a costa de un mayor tiempo de procesamiento, la computación criptográfica es la elección ideal. Si, por el contrario, se requiere un alto rendimiento en tiempo real y se confía en la integridad del hardware, la computación confidencial es la alternativa más práctica.

El futuro de la computación segura podría estar en la integración de ambas tecnologías, combinando la robustez de la criptografía avanzada con la eficiencia de los entornos confiables de hardware. Por ahora, cada organización debe evaluar sus requisitos específicos y las capacidades de su infraestructura antes de adoptar una solución.

En la era digital, proteger los datos no es solo una cuestión técnica, sino un compromiso ético con la privacidad y la confianza de los usuarios. Tanto la computación criptográfica como la confidencial son herramientas clave para garantizar un manejo seguro de la información, marcando el camino hacia un mundo digital más protegido y confiable.

Impacto en los modelos de aprendizaje: un enfoque paradigmático

Un aspecto crucial a considerar sobre la computación segura es cómo puede impactar negativamente el entrenamiento de modelos de aprendizaje automático, especialmente en entornos sensibles como el de la salud. Si bien garantizar la privacidad de los datos es imprescindible en este sector, la naturaleza altamente restrictiva de las técnicas de computación segura, particularmente la computación criptográfica, puede convertirse en un obstáculo significativo para el desarrollo y la implementación eficiente de estos modelos.

El entrenamiento de modelos de aprendizaje automático, como los utilizados para detectar enfermedades, predecir tratamientos o personalizar diagnósticos, implica procesar grandes cantidades de datos en múltiples iteraciones. En un entorno que prioriza la privacidad mediante métodos criptográficos, como el cifrado homomórfico o el cómputo multipartito seguro, cada cálculo debe realizarse sobre datos cifrados. Aunque esto protege completamente la información de los pacientes, la sobrecarga computacional resultante es sustancial. Operaciones que en un entorno tradicional tardarían segundos pueden extenderse a horas o días. Esto no solo retrasa el entrenamiento del modelo, sino que también limita la capacidad de iterar rápidamente y ajustar parámetros, lo cual es esencial para mejorar la precisión del modelo.

En el caso de la computación confidencial, aunque la eficiencia mejora considerablemente, sigue existiendo un compromiso inherente. Dado que se depende de hardware especializado, cualquier limitación en la disponibilidad o la capacidad de los entornos confiables podría restringir el acceso a los recursos necesarios para procesar datos masivos. Además, este enfoque no elimina completamente las preocupaciones sobre la privacidad, ya que el procesamiento de datos en texto plano dentro de los enclaves sigue generando riesgos residuales, especialmente si el hardware es comprometido.

En un sector como la salud, donde los datos son extremadamente sensibles y la precisión del modelo puede marcar la diferencia entre un diagnóstico temprano o uno tardío, este dilema se magnifica. La necesidad de equilibrar privacidad y eficiencia crea una tensión que todavía no se ha resuelto completamente. Las soluciones actuales exigen compromisos que pueden impactar tanto en la seguridad de los datos como en la velocidad y calidad del entrenamiento.

La reflexión más importante aquí es que, aunque la computación segura representa un avance crucial en la protección de la privacidad, no es una panacea. Para aplicaciones críticas como el entrenamiento de modelos en el sector salud, es imprescindible seguir investigando y desarrollando tecnologías híbridas que combinen la privacidad estricta con una eficiencia adecuada. Sin este equilibrio, corremos el riesgo de que las ventajas de la computación segura se vean eclipsadas por sus limitaciones prácticas, lo que podría retrasar la adopción de soluciones innovadoras en áreas donde son más necesarias.

La Perspectiva Disruptiva de los Chiplets y su Implicación en la IA

En el mundo de la tecnología, a veces surge una innovación que no solo redefine cómo hacemos las cosas, sino que nos obliga a replantearnos lo que creíamos posible. Los chiplets son una de esas innovaciones. A diferencia del modelo tradicional en el que todo se integra en un solo chip de silicio, los chiplets permiten ensamblar diferentes piezas especializadas en un mismo paquete. Este enfoque modular está cambiando las reglas del juego en la industria de los semiconductores. En estas semanas me encuentro reformulando el temario de una de las asignaturas que imparto en la Universidad de Almería (Periféricos e Interfaces) y una de las discusiones más interesantes, al margen de la escala de integración -que afecta tanto a procesador como a CHIPSET- es el giro arquitectónico hacía el chiplet.

La reflexión es ¿tiene la IA un argumento de peso en el giro hacia esta tecnología? China y EE.UU. están deteniendo su producción de procesadores genéricos para centrarse en procesadores orientados a la IA. ¿Es este el motivo? Este post consiste en una serie de reflexiones que luego, quizá si o quizá no, usaré en clase.

La idea detrás de los chiplets no es nueva, pero su implementación a gran escala está alcanzando una madurez que los posiciona como una solución viable frente a los crecientes desafíos de la tecnología moderna. Una de sus ventajas más notables es la capacidad de mejorar el rendimiento sin necesidad de miniaturizar cada componente individual, lo que ha permitido a la industria superar las limitaciones físicas que enfrenta la Ley de Moore. Además, al permitir reemplazar solo las piezas defectuosas, se reduce el desperdicio, lo que los hace más rentables. Es como construir con bloques de Lego: si algo falla, no necesitas reconstruir todo desde cero.

En el caso de la inteligencia artificial, la llegada de los chiplets no podría haber sido más oportuna. La IA demanda un procesamiento masivo de datos y un acceso ultrarrápido a la memoria, dos áreas donde los chiplets brillan. La posibilidad de colocar núcleos de procesamiento y módulos de memoria extremadamente cerca unos de otros mejora notablemente la velocidad de transferencia de datos. Incluso hay iniciativas como los chiplets ópticos, que están llevando estas capacidades a nuevos niveles, maximizando el ancho de banda entre componentes. Y es precisamente este desarrollo el que me permite contarlos en la asignatura de Periféricos e Interfaces, su empleo como pieza fundamental en la E/S.

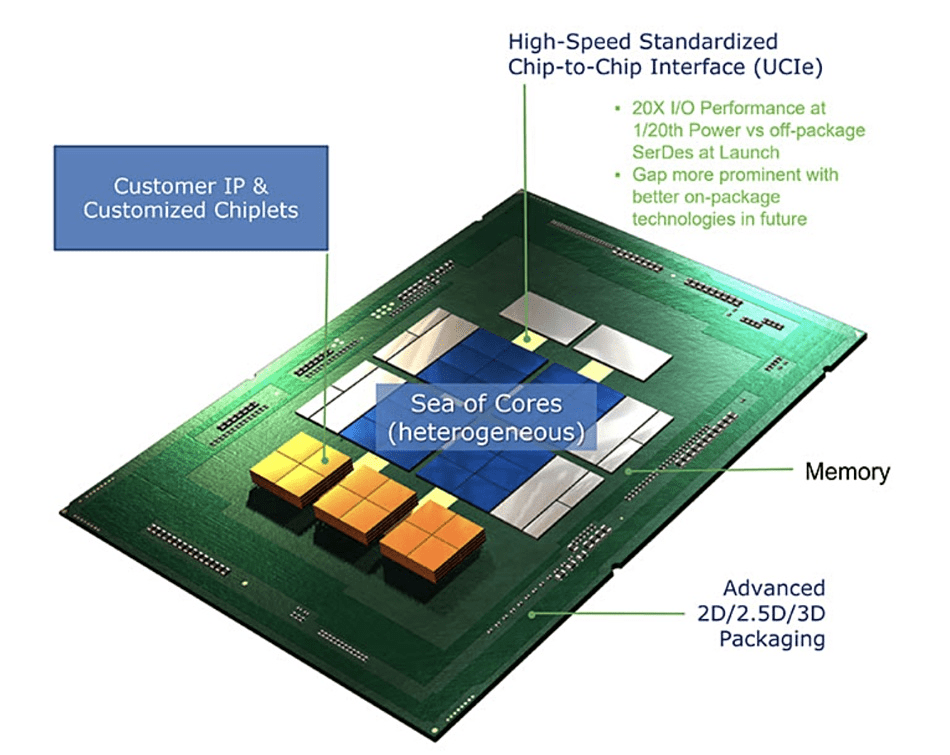

Sin embargo, como toda tecnología emergente, los chiplets también enfrentan retos. La falta de estándares unificados es uno de los principales obstáculos, ya que cada fabricante tiende a desarrollar su propio ecosistema. Para resolverlo, se han impulsado esfuerzos como el estándar Universal Chiplet Interconnect Express (UCIe) (amplía información en este enlace de ARM y en este que es justamente de UCIe) -ver siguiente figura-, que busca garantizar que chiplets de distintos proveedores puedan comunicarse de manera efectiva. Además, integrar estos módulos en un paquete funcional no es tarea sencilla. Se requieren avances en las técnicas de ensamblaje y conexión, que actualmente suponen un reto técnico significativo.

El interés en los chiplets no es solo tecnológico, sino también estratégico. Países como Estados Unidos están apostando fuerte por esta tecnología, conscientes de su potencial para liderar el mercado de semiconductores. Programas como el CHIPS and Science Act y otras iniciativas similares son muestra del enfoque geopolítico que acompaña a esta innovación.

Los chiplets no solo están abriendo nuevas posibilidades para el diseño de hardware, sino que también están transformando nuestra manera de entender la computación. Aunque todavía hay camino por recorrer, su capacidad para ofrecer soluciones eficientes, flexibles y adaptadas a las necesidades de aplicaciones avanzadas como la inteligencia artificial los coloca en el centro de la próxima gran revolución tecnológica.

Legitimidad popular del pabellón español actual.

A pesar de que la modificación de la bandera fue por motivos de descontento monárquico, la imposición por el gobierno provisional no recogía el espíritu que algunos le quieren asignar.

¿Qué opinión tienes antes de leer este post y después? ¿Tienes documentación que aportar? Si es así, la puedo continuar en un hilo.

La bandera republicana española, adoptada oficialmente durante la Segunda República (1931-1939), tiene un origen complejo que combina consideraciones históricas, simbólicas y políticas. Se caracteriza por sus tres franjas horizontales de colores rojo, amarillo y morado, en contraste con la bandera actual de España, que conserva el diseño bicolor de rojo y gualda (amarillo) heredado de la tradición monárquica.

Origen de la bandera republicana

Elección del morado como símbolo:

El morado se añadió como tercera franja para representar a Castilla, en la creencia (hoy cuestionada) de que era un color distintivo de los comuneros castellanos que se rebelaron contra Carlos I en el siglo XVI. Sin embargo, investigaciones posteriores señalan que los pendones comuneros eran en realidad carmesíes, no morados.

Este color también simbolizaba un esfuerzo por incluir a la tradición popular y a sectores descontentos con la monarquía.

Significado político:

La bandera representaba una ruptura simbólica con el pasado monárquico. El nuevo diseño pretendía reflejar un modelo más inclusivo y democrático, en sintonía con el espíritu republicano.

Emblema del escudo:

El escudo republicano mantenía elementos tradicionales como el león y el castillo, pero incorporó símbolos modernos como la corona mural (en lugar de la real) para reflejar un estado sin monarquía.

La bandera actual y su legitimidad histórica

La bandera actual (rojo-gualda-rojo) fue adoptada oficialmente durante el reinado de Isabel II en 1843, pero su origen se remonta al siglo XVIII bajo Carlos III. Este diseño fue elegido por su visibilidad en el mar, ya que destacaba frente a las enseñas de otras naciones. Representa la continuidad histórica de España, consolidándose como el símbolo nacional más longevo.

Tras la Guerra Civil (1936-1939), el régimen franquista conservó la bandera rojigualda, aunque modificó su escudo. Con la llegada de la democracia y la Constitución de 1978, el diseño se ajustó nuevamente para eliminar elementos franquistas, consolidándose como el símbolo de un Estado democrático y plural.

¿Imposición o elección popular de la bandera republicana?

Es un error afirmar que la bandera republicana fue impuesta por el pueblo. Su adopción se formalizó mediante un decreto gubernamental el 27 de abril de 1931, apenas dos semanas después de la proclamación de la Segunda República. Fue una decisión del gobierno provisional, en la que participaron sectores políticos republicanos, pero no hubo una consulta popular sobre el cambio de bandera. Más bien, la nueva enseña simbolizó el régimen republicano, no una demanda espontánea de la sociedad.

En contraste, la bandera actual ha sido refrendada democráticamente a través de la Constitución de 1978, aprobada en referéndum por una amplia mayoría de los ciudadanos. Este hecho le otorga una legitimidad democrática que la bandera republicana, aunque representativa de un periodo histórico, no tuvo en su momento.

Por tanto…

La bandera republicana fue una creación política y simbólica diseñada para marcar una ruptura con la monarquía, mientras que la bandera actual representa una continuidad histórica y ha sido ratificada en un marco democrático. Aunque ambas tienen valor histórico, la legitimidad de la bandera actual está cimentada en el consenso popular de la transición democrática, algo que no puede decirse de la bandera republicana, cuyo diseño fue más bien una imposición gubernamental ligada al régimen de la Segunda República.